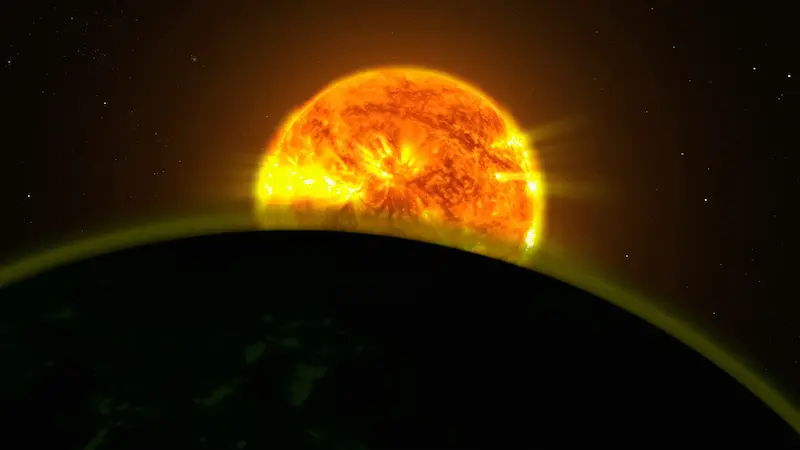

Se você está acompanhando a corrida atual pela inteligência artificial, provavelmente já percebeu o padrão: cada salto em modelos e capacidades vem acompanhado de uma conta enorme de eletricidade… e também de água. Por isso, várias gigantes de tecnologia dos Estados Unidos estão impulsionando com força uma ideia que soa como ficção científica, mas que começa a sair do papel (ou melhor, a entrar em órbita): criar centros de dados no espaço. A proposta é tão direta quanto ambiciosa: colocar servidores em satélites, alimentá-los com energia solar quase constante e usar o vácuo espacial para lidar com o calor sem depender de sistemas de resfriamento à base de água.

No fundo, a intenção é clara: se, na Terra, a infraestrutura para IA está pressionando redes elétricas e recursos locais, por que não levar parte do processamento para a órbita, onde a geração fotovoltaica pode ser muito mais eficiente e o resfriamento não exige litros e litros de água? A resposta ainda não é um “sim” definitivo, mas os sinais se acumulam: o Google já tem um cronograma, a NVIDIA já colocou hardware em órbita, e SpaceX, OpenAI e outras grandes forças do setor têm demonstrado interesse.

O que é um centro de dados espacial e por que isso interessa agora

Quando se fala em “centros de dados no espaço”, não se trata de um único satélite gigante servindo como um servidor flutuante, e sim de uma abordagem mais modular: lançar grupos de satélites com capacidade de computação e comunicação que funcionem como infraestrutura de processamento e armazenamento na órbita terrestre. A ideia é substituir, ao menos em parte, o crescimento desenfreado de centros de dados em solo, especialmente para cargas de trabalho ligadas à IA.

O principal argumento técnico gira em torno de energia e resfriamento. Em órbita, a eletricidade pode ser gerada com células fotovoltaicas praticamente de forma contínua, e o Google indicou que a eficiência de geração solar pode chegar a ser até oito vezes maior do que a obtida na Terra. Além disso, o calor residual pode ser dissipado no espaço, o que elimina a dependência de grandes volumes de água para refrigeração — um ponto sensível em muitas regiões onde a demanda de centros de dados já está pressionando os recursos hídricos.

O contexto que empurra essa busca por alternativas é o consumo previsto. A BloombergNEF estima que a demanda elétrica de centros de dados nos Estados Unidos chegará a 106 GWh em 2035, uma escala comparável a mais de 100 usinas nucleares de grande porte. O dado, inclusive, foi revisado para cima em 36% em relação a uma projeção de apenas sete meses antes e fica em torno de 2,6 vezes a demanda estimada para 2025. Com esse cenário, não surpreende que estejam surgindo resistências locais a novas instalações e preocupação com impactos em tarifas e no planejamento energético.

E aí surge a pergunta retórica inevitável para qualquer leitor com um lado mais geek: se a IA quer crescer “sem freio”, será que vamos continuar tentando colocar tudo na mesma tomada aqui na Terra?

Google, NVIDIA e Starcloud: os primeiros passos reais

Nesse tabuleiro, o Google (Alphabet) já deu nome e data ao seu movimento: Project Suncatcher. Segundo o que foi anunciado, a empresa planeja lançar dois satélites experimentais no início de 2027, equipados com seus semicondutores de IA de alto desempenho, as TPUs. A proposta é escalar por meio de vários satélites pequenos que combinem painéis solares e capacidade de computação, funcionando em conjunto como um centro de dados distribuído em órbita.

O que dá ainda mais credibilidade ao conceito é que ele não fica só no plano das intenções: uma startup apoiada pela NVIDIA, a Starcloud, saiu na frente. A empresa levou ao espaço, em outubro, o semicondutor de IA NVIDIA H100 e seu primeiro satélite — que, segundo a NVIDIA, pesa 60 quilos e tem um tamanho aproximado ao de uma geladeira pequena. O ponto aqui não é apenas a miniaturização, mas o recado para o mercado: já existe hardware de IA operando fora da atmosfera.

Mais do que isso, foi reportado que o sistema continuou em uso e permitiu executar modelos de IA de forma contínua. Em paralelo, a Starcloud também demonstrou um marco simbólico: treinar um modelo de IA no espaço em pequena escala, usando o modelo Gemma do Google em um satélite. É um primeiro passo, mas é exatamente o tipo de teste que transforma uma ideia futurista em um roadmap com metas mensuráveis.

Seguindo a mesma lógica, a Starcloud já mira a próxima etapa: planeja lançar um satélite maior com um cluster de GPUs no fim de 2026 e pretende oferecer serviços de computação espacial no início de 2027. Em uma indústria que muitas vezes vive de promessas, esses prazos fazem diferença — ainda que tudo esteja, por enquanto, no campo experimental.

SpaceX e OpenAI: oportunidades enormes, barreiras do mesmo tamanho

Se há uma empresa que se encaixa quase “perfeitamente demais” nessa história, é a SpaceX, por um motivo óbvio: ela controla foguetes, satélites e custos de lançamento dentro do mesmo ecossistema. Nesse contexto, foi mencionado que a SpaceX prepara uma possível abertura de capital em 2026 e que parte do financiamento poderia ser direcionada a centros de dados de IA no espaço. Elon Musk chegou a comentar que a ideia é boa e sugeriu que, em cerca de cinco anos, o espaço poderia se tornar o lugar mais barato para treinar IA — uma afirmação provocativa, mas que toca no coração do problema: o custo de energia e infraestrutura em terra.

A OpenAI também entra no radar. Seu CEO, Sam Altman, já disse no passado que montar centros de dados na Terra “talvez não faça sentido”, e foi reportado o interesse por opções de centros de dados espaciais, incluindo movimentos para se aproximar de startups do setor de foguetes. Enquanto isso, o gasto com infraestrutura terrestre segue subindo: foi indicado que a OpenAI planeja investir 1,4 trilhão de dólares em centros de dados nos próximos oito anos, e que a Microsoft prevê gastar 80 bilhões de dólares no ano fiscal de 2025 — com Meta e Amazon também investindo pesado. O resultado: redes elétricas e sistemas de água sob pressão, especialmente nos Estados Unidos.

Agora, o grande “porém” do centro de dados espacial continua o mesmo: os custos e os riscos físicos da órbita. O Google analisou que, se o custo de lançamento para a órbita baixa cair para 200 dólares por quilo em meados da década de 2030, o projeto estaria perto de ser viável. Já consultorias como a McKinsey colocam o custo atual na faixa de 1.500 dólares por quilo, e outras estimativas apontam para algo em torno de 2.000 dólares por quilo. Em outras palavras: a economia do plano depende de uma queda drástica no preço de colocar “metal” em órbita.

A essa equação se somam limitações técnicas nada pequenas. A radiação acelera o envelhecimento e aumenta a probabilidade de falhas na eletrônica — algo crítico quando falamos de hardware de alto desempenho. Também existe o risco de colisões com lixo espacial, um problema que já deixou de ser anedótico: foi citado o caso de uma nave chinesa que sofreu danos em uma janela por causa de um fragmento pequeno, lembrando que a órbita é um ambiente cada vez mais congestionado. E, embora o vácuo permita dissipar calor sem água, o gerenciamento térmico de chips no espaço ainda é visto como um desafio que não está totalmente resolvido.

Assim, por enquanto, o centro de dados espacial é uma promessa com protótipos reais e padrinhos gigantes, mas também um campo em que ainda se está esbarrando na física, no preço por quilo e na fragilidade da eletrônica fora da proteção atmosférica. O interessante é que, com a IA puxando a demanda como um motor em alta rotação, a indústria começa a considerar seriamente opções que, há poucos anos, só caberiam em um roteiro de ficção científica… ou naquela discussão interminável de fórum que nunca acaba.