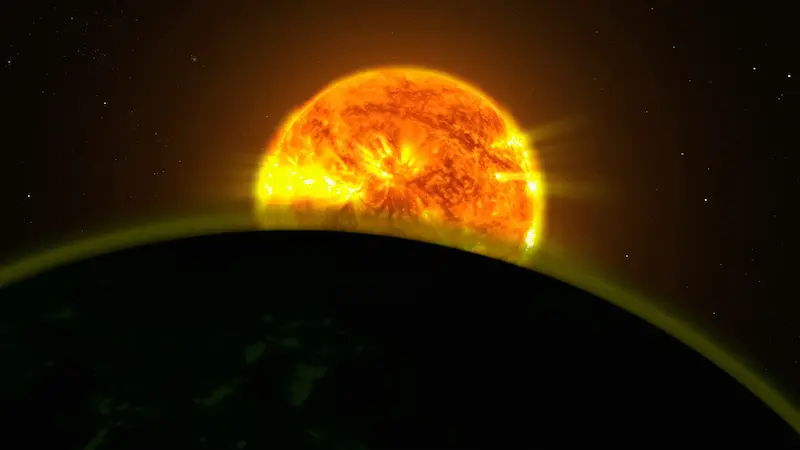

Si vous suivez la course actuelle à l’intelligence artificielle, vous avez sans doute remarqué le schéma : chaque bond en avant des modèles et des capacités s’accompagne d’une facture énorme en électricité… et aussi en eau. C’est pourquoi plusieurs géants technologiques américains poussent fortement une idée qui ressemble à de la science-fiction, mais qui commence à se concrétiser (ou plutôt à se mettre en orbite) : créer des centres de données dans l’espace. La proposition est aussi simple qu’ambitieuse : installer des serveurs sur des satellites, les alimenter grâce à une énergie solaire quasi constante et exploiter le vide spatial pour gérer la chaleur, sans dépendre de systèmes de refroidissement à l’eau.

Au fond, l’intention est claire : si, sur Terre, l’infrastructure de l’IA met sous tension les réseaux électriques et les ressources locales, pourquoi ne pas déplacer une partie du calcul en orbite, où la production photovoltaïque peut être bien plus efficace et où le refroidissement n’exige pas des litres et des litres d’eau ? La réponse n’est pas encore un « oui » définitif, mais les signaux s’accumulent : Google a déjà un calendrier, NVIDIA a déjà placé du matériel en orbite, et SpaceX, OpenAI et d’autres grandes figures du secteur ont montré leur intérêt.

Qu’est-ce qu’un centre de données spatial, et pourquoi cela intéresse maintenant

Quand on parle de « centres de données dans l’espace », il ne s’agit pas d’un unique satellite gigantesque servant de serveur flottant, mais d’une approche plus modulaire : déployer des groupes de satellites dotés de capacités de calcul et de communication qui fonctionnent comme une infrastructure de traitement et de stockage en orbite terrestre. L’idée est de remplacer, au moins en partie, la croissance effrénée des centres de données au sol, en particulier pour des charges de travail liées à l’IA.

Le principal argument technique concerne l’énergie et le refroidissement. En orbite, l’électricité peut être produite avec des cellules photovoltaïques de manière presque continue, et Google a indiqué que l’efficacité de production solaire pourrait être jusqu’à huit fois supérieure à celle obtenue sur Terre. De plus, la chaleur résiduelle peut être dissipée dans l’espace, ce qui supprime la dépendance à de gros volumes d’eau pour le refroidissement — un point sensible dans de nombreuses régions où la demande des centres de données met déjà les ressources hydriques sous pression.

Le contexte qui pousse à chercher des alternatives, c’est la consommation prévue. BloombergNEF estime que la demande électrique des centres de données aux États-Unis atteindra 106 GWh en 2035, un ordre de grandeur comparable à plus de 100 centrales nucléaires de grande taille. Ce chiffre a en plus été révisé à la hausse de 36% par rapport à une prévision datant de seulement sept mois, et se situe autour de 2,6 fois la demande projetée pour 2025. Dans ce contexte, il n’est pas étonnant de voir émerger des résistances locales à de nouvelles installations et des inquiétudes quant à l’impact sur les tarifs et la planification énergétique.

Et c’est là qu’apparaît la question rhétorique inévitable pour tout lecteur avec une fibre geek : si l’IA veut grandir « à fond », est-ce vraiment en restant branchés sur la même prise terrestre qu’on va y arriver ?

Google, NVIDIA et Starcloud : les premiers pas concrets

Sur cet échiquier, Google (Alphabet) a déjà donné un nom et une date à son initiative : Project Suncatcher. D’après l’annonce, l’entreprise prévoit de lancer deux satellites expérimentaux début 2027, équipés de ses semi-conducteurs IA haute performance, les TPU. L’approche consiste à monter en puissance via de multiples petits satellites combinant panneaux solaires et capacité de calcul, et opérant ensemble comme un centre de données distribué en orbite.

Ce qui renforce encore la crédibilité du concept, c’est qu’il ne se limite pas à des intentions : une startup soutenue par NVIDIA, Starcloud, a pris de l’avance sur le terrain. L’entreprise a envoyé dans l’espace en octobre le semi-conducteur d’IA NVIDIA H100 et son premier satellite : selon NVIDIA, il pèse 60 kilogrammes et affiche un format proche de celui d’un petit réfrigérateur. L’enjeu ici n’est pas seulement la miniaturisation, mais le signal industriel : du matériel IA opère déjà hors de l’atmosphère.

Plus encore, il a été rapporté que le système a continué d’être utilisé et qu’il a permis d’exécuter des modèles d’IA de manière continue. En parallèle, Starcloud a aussi démontré une étape symbolique : entraîner un modèle d’IA dans l’espace à petite échelle, en utilisant le modèle Gemma de Google sur un satellite. C’est un premier pas, mais c’est précisément le type d’essai qui transforme une idée futuriste en une feuille de route avec des jalons mesurables.

Dans la même logique, Starcloud vise déjà la phase suivante : l’entreprise prévoit de lancer un satellite plus grand avec un cluster de GPU d’ici fin 2026, et ambitionne de proposer des services de calcul spatial début 2027. Dans un secteur souvent nourri de promesses, ces calendriers font la différence, même si l’on reste encore au stade expérimental.

SpaceX et OpenAI : opportunités immenses, obstacles tout aussi grands

S’il y a une entreprise qui s’insère dans cette histoire de façon presque « trop parfaite », c’est SpaceX, pour une raison évidente : elle maîtrise les fusées, les satellites et les coûts de lancement au sein du même écosystème. Dans ce contexte, il a été avancé que SpaceX préparerait une possible introduction en Bourse en 2026 et qu’une partie du financement pourrait être consacrée à des centres de données d’IA dans l’espace. Elon Musk a même commenté que l’idée était bonne, allant jusqu’à suggérer que l’espace pourrait devenir l’endroit le moins cher pour entraîner de l’IA d’ici cinq ans — une déclaration provocatrice, mais qui vise le cœur du problème : le coût énergétique et celui des infrastructures au sol.

OpenAI figure aussi sur le radar. Son CEO, Sam Altman, a déjà indiqué par le passé que construire des centres de données sur Terre « n’a peut-être pas de sens », et son intérêt pour des options de centres de données spatiaux a été rapporté, notamment via des démarches visant à se rapprocher de startups du secteur des fusées. Pendant ce temps, les dépenses en infrastructures terrestres continuent de grimper : il a été indiqué qu’OpenAI prévoit d’investir 1,4 billion de dollars dans des centres de données au cours des huit prochaines années, et que Microsoft anticipe 80.000 millions de dollars de dépenses sur l’exercice fiscal 2025, avec Meta et Amazon qui renforcent également leurs investissements. Résultat : des réseaux électriques et des systèmes d’approvisionnement en eau sous pression, en particulier aux États-Unis.

Reste toutefois le grand « mais » du centre de données spatial : les coûts et les risques physiques en orbite. Google a analysé que si le coût de lancement en orbite basse descendait à 200 dollars par kilogramme au milieu des années 2030, le projet serait proche d’être viable, tandis que des cabinets comme McKinsey situent le coût actuel autour de 1.500 dollars par kilogramme, et d’autres estimations l’évaluent à environ 2.000 dollars par kilogramme. Autrement dit : l’économie du modèle dépend d’une baisse drastique du prix pour mettre du « métal » en orbite.

À cette équation s’ajoutent des limites techniques loin d’être marginales. Les radiations accélèrent le vieillissement et augmentent le risque de défaillances électroniques, ce qui est critique lorsqu’il s’agit de matériel hautes performances. Il y a aussi le risque de collisions avec des débris spatiaux, un problème qui n’a plus rien d’anecdotique : le cas d’un vaisseau chinois dont une fenêtre aurait été endommagée par un petit fragment a été cité, rappelant que l’orbite devient un environnement de plus en plus encombré. Et si le vide permet d’évacuer la chaleur sans eau, la gestion thermique des puces dans l’espace reste considérée comme un défi qui n’est pas entièrement résolu.

Pour l’instant, le centre de données spatial reste donc une promesse appuyée par des prototypes réels et par des parrains géants, mais aussi un terrain où l’on se heurte encore à la physique, au prix par kilo et à la fragilité de l’électronique en dehors de la protection atmosphérique. Ce qui est intéressant, c’est qu’avec une IA qui tire la demande comme un moteur à plein régime, l’industrie commence à envisager sérieusement des options qui, il y a quelques années, n’auraient eu leur place que dans un scénario de science-fiction… ou dans une interminable discussion de forum, de celles qui ne finissent jamais.