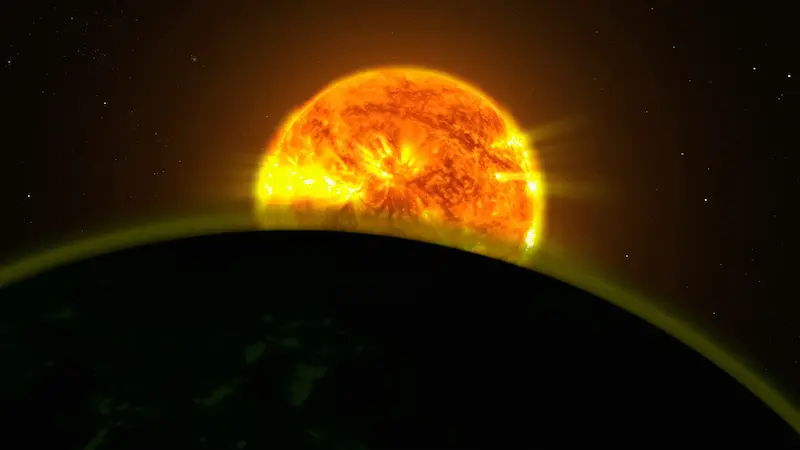

Si estás siguiendo la carrera actual por la inteligencia artificial, ya habrás notado el patrón: cada salto en modelos y capacidades trae detrás una factura enorme en electricidad… y también en agua. Por eso, varias tecnológicas estadounidenses están empujando con fuerza una idea que suena a ciencia ficción, pero que empieza a aterrizar (o más bien a orbitar): crear centros de datos en el espacio. La propuesta es tan directa como ambiciosa: montar servidores en satélites, alimentarlos con energía solar casi constante y usar el vacío espacial para gestionar el calor sin depender de sistemas de refrigeración por agua.

En el fondo, la intención es clara: si en la Tierra la infraestructura para IA está tensionando redes eléctricas y recursos locales, ¿por qué no desplazar parte del cómputo a la órbita, donde la generación fotovoltaica puede ser mucho más eficiente y la refrigeración no exige litros y litros de agua? La respuesta aún no es un “sí” definitivo, pero las señales se acumulan: Google ya tiene calendario, NVIDIA ya ha puesto hardware en órbita y SpaceX, OpenAI y otras grandes figuras del sector han mostrado interés.

Qué es un centro de datos espacial y por qué interesa ahora

Cuando se habla de “centros de datos en el espacio”, no se trata de un único satélite gigantesco haciendo de servidor flotante, sino de un enfoque más modular: desplegar grupos de satélites con capacidad de computación y comunicación que funcionen como infraestructura de procesamiento y almacenamiento en órbita terrestre. La idea es sustituir, al menos en parte, el crecimiento desbocado de centros de datos en tierra, especialmente para cargas de trabajo relacionadas con IA.

El principal argumento técnico gira en torno a la energía y la refrigeración. En órbita, la electricidad puede generarse con células fotovoltaicas prácticamente de forma continua, y Google ha indicado que la eficiencia de generación solar puede llegar a ser hasta ocho veces superior frente a la que se obtiene en tierra. Además, el calor residual puede liberarse al espacio, lo que elimina la dependencia de grandes volúmenes de agua para refrigeración, un punto delicado en muchas regiones donde la demanda de centros de datos ya está poniendo contra las cuerdas a los recursos hídricos.

El contexto que empuja esta búsqueda de alternativas es el consumo previsto. BloombergNEF estima que la demanda eléctrica de centros de datos en Estados Unidos alcanzará 106 GWh en 2035, una magnitud que se compara con más de 100 centrales nucleares de gran escala. El dato, además, se revisó al alza un 36% respecto a una previsión de apenas siete meses antes y se sitúa en torno a 2,6 veces la demanda proyectada para 2025. Con este panorama, no sorprende que estén apareciendo resistencias locales a nuevas instalaciones y preocupación por el impacto en tarifas y planificación energética.

Y aquí surge la pregunta retórica inevitable para cualquier lector con vena geek: si la IA quiere crecer “a lo bestia”, ¿de verdad vamos a seguir intentando meterlo todo en el mismo enchufe terrestre?

Google, NVIDIA y Starcloud: los primeros pasos reales

En este tablero, Google (Alphabet) ya ha puesto nombre y fecha a su movimiento: Project Suncatcher. Según lo anunciado, la compañía planea lanzar dos satélites experimentales a principios de 2027, equipados con sus semiconductores de IA de alto rendimiento, las TPU. El planteamiento es escalar a través de múltiples satélites pequeños que combinen paneles solares y capacidad de cómputo, funcionando en conjunto como un centro de datos distribuido en órbita.

La pieza que le da aún más credibilidad al concepto es que no se queda en planes: una startup apoyada por NVIDIA, Starcloud, se ha adelantado en el terreno. La compañía llevó al espacio en octubre el semiconductor de IA NVIDIA H100 y su primer satélite, según NVIDIA, pesa 60 kilogramos y tiene un tamaño aproximado al de un frigorífico pequeño. La clave aquí no es solo la miniaturización, sino el mensaje industrial: ya hay hardware de IA operando fuera de la atmósfera.

Más aún, se ha reportado que el sistema siguió utilizándose, y que permitió ejecutar modelos de IA de forma continuada. En paralelo, Starcloud también demostró un hito simbólico: entrenar un modelo de IA en el espacio a pequeña escala, utilizando el modelo Gemma de Google en un satélite. Es un paso inicial, pero es exactamente el tipo de prueba que convierte una idea futurista en un roadmap con hitos medibles.

Con la misma lógica, Starcloud ya mira a una siguiente fase: planea lanzar un satélite mayor con un clúster de GPU hacia finales de 2026 y apunta a ofrecer servicios de computación espacial a principios de 2027. En una industria que suele vivir de promesas, estos calendarios marcan diferencia, aunque todavía estemos en el tramo experimental.

SpaceX y OpenAI: oportunidades enormes, barreras igual de grandes

Si hay una empresa que encaja de forma casi “demasiado perfecta” en esta historia es SpaceX, por una razón evidente: controla cohetes, satélites y costes de lanzamiento dentro del mismo ecosistema. En este contexto, se ha señalado que SpaceX prepara una posible salida a bolsa en 2026 y que parte de la financiación podría destinarse a centros de datos de IA en el espacio. Elon Musk incluso ha comentado que la idea es buena y ha llegado a sugerir que el espacio podría convertirse en el lugar más barato para entrenar IA en unos cinco años, una afirmación que suena provocadora, pero que apunta al corazón del problema: el coste energético y de infraestructura en tierra.

También OpenAI aparece en el radar. Su CEO, Sam Altman, ha señalado en el pasado que montar centros de datos en la Tierra “puede que no tenga sentido”, y se ha informado de su interés por opciones de centros de datos espaciales, incluyendo movimientos para aproximarse a startups del sector de cohetes. Mientras tanto, el gasto en infraestructura terrestre sigue escalando: se ha indicado que OpenAI planea invertir 1,4 billones de dólares en centros de datos en los próximos ocho años, y que Microsoft prevé gastar 80.000 millones de dólares en el ejercicio fiscal 2025, con Meta y Amazon también metiendo músculo inversor. El resultado: redes eléctricas y sistemas de agua bajo presión, especialmente en Estados Unidos.

Ahora bien, el gran “pero” del centro de datos espacial sigue siendo el mismo: los costes y los riesgos físicos de la órbita. Google ha analizado que, si el coste de lanzamiento a órbita baja se redujera a 200 dólares por kilogramo a mediados de la década de 2030, el proyecto estaría cerca de ser viable, mientras que consultoras como McKinsey sitúan el coste actual en el entorno de 1.500 dólares por kilogramo, y otras estimaciones lo colocan alrededor de 2.000 dólares por kilogramo. En otras palabras: la economía del plan depende de que el precio de poner “metal” en órbita caiga de forma drástica.

A esa ecuación se suman limitaciones técnicas nada menores. La radiación acelera el envejecimiento y la probabilidad de fallos en electrónica, algo crítico cuando hablamos de hardware de alto rendimiento. También está el riesgo de colisiones con basura espacial, un problema que ya no es anecdótico: se ha citado el caso de una nave china que sufrió daños en una ventana por un fragmento pequeño, recordando que la órbita es un entorno cada vez más congestionado. Y aunque el vacío permite evacuar calor sin agua, la gestión térmica de chips en el espacio sigue considerándose un reto por resolver del todo.

Así que, por ahora, el centro de datos espacial es una promesa con prototipos reales y con padrinos gigantes, pero también un campo donde todavía se está peleando con la física, el precio por kilo y la fragilidad de la electrónica fuera de la protección atmosférica. Lo interesante es que, con la IA tirando de demanda como un motor a máximas revoluciones, la industria está empezando a considerar seriamente opciones que hace pocos años solo habrían encajado en un guion de ciencia ficción… o en una conversación eterna de foro, de esas que nunca terminan.