Wenn du schon länger KI-Assistenten nutzt, kennst du vermutlich dieses Gefühl: Sie „wissen viel“, aber wenn es darauf ankommt, musst du den konkreten Fakt doch wieder in deinen E-Mails, Fotos oder im Verlauf zusammensuchen. Genau diese Lücke will Google mit Personal Intelligence schließen – einer neuen Funktion, mit der sich Gemini personalisieren lässt, indem Google-Apps mit einem einzigen Tipp verbunden werden. Das Feature startet als Beta in den USA und soll laut dem Unternehmen dafür sorgen, dass Gemini persönlicher, proaktiver und leistungsfähiger wird … ohne dass dein digitales Leben dabei zur offenen Schublade wird.

Das Prinzip ist schnell erklärt: Aktivierst du diese Option, kann Gemini über mehrere Quellen hinweg schlussfolgern (zum Beispiel zwischen E-Mail und Fotos) und außerdem konkrete Details gezielt abrufen, wenn du danach fragst – vom Inhalt einer Mail bis hin zu einer Information, die in einem Bild steckt. Der Unterschied zum typischen Assistenten, der nur „weiß, was im Internet steht“: Hier lieferst du den Kontext selbst, indem du deine eigenen Apps verknüpfst – und das verändert die Art der Antworten, die Gemini geben kann.

Google positioniert das als Schritt hin zu einem Assistenten, der nicht nur die Welt versteht, sondern dich. Und ehrlich gesagt: Wenn es gut funktioniert, ist es genau die Art von Idee, die wir seit Jahren in der Geek-Kultur vor Augen haben – inklusive der obligatorischen Frage: „Okay, aber was ist mit meiner Privatsphäre?“

Was Personal Intelligence ist – und was sich in Gemini verändert

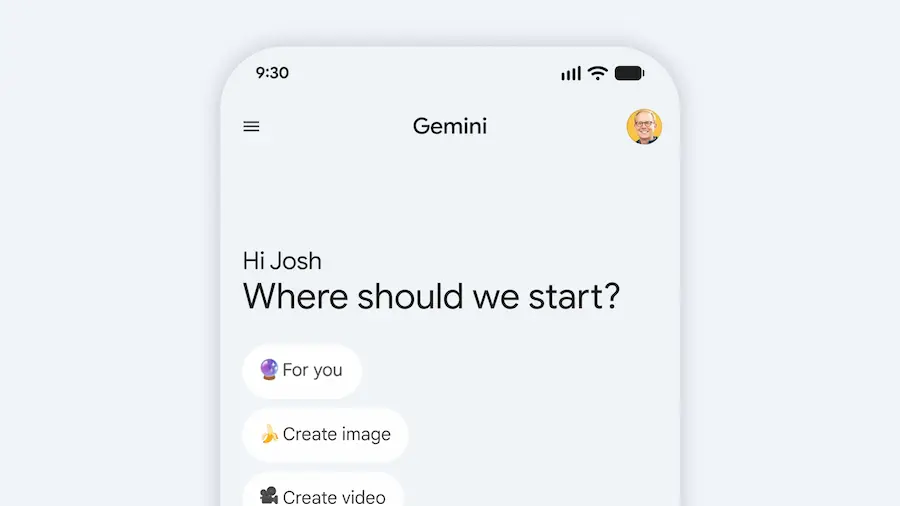

Personal Intelligence bezeichnet die Gemini-Erfahrung auf Basis von Connected Apps – also dem Verbinden ausgewählter Google-Anwendungen, damit der Assistent Informationen nutzen kann, die bereits in deinem Konto liegen, und dich gezielter unterstützt. Laut offizieller Ankündigung erfolgt die Verknüpfung unkompliziert, mit einer Konfiguration, die auf Sicherheit ausgelegt ist.

In dieser ersten Phase kann sich das System mit Gmail, Google Fotos, YouTube und der Suche per Fingertipp verbinden. Der Mehrwert liegt nicht nur darin, Daten zu „lesen“, sondern Fähigkeiten zu kombinieren: Einerseits kann Gemini punktgenaue Informationen abrufen (etwa ein Detail aus einer Mail oder aus einem Foto) und andererseits zwischen Quellen schlussfolgern, um eine hilfreichere Antwort zu bauen – selbst dann, wenn deine Frage nicht perfekt formuliert ist oder Kontext benötigt.

Google nennt genau diese beiden Punkte als zentrale Stärken: mit komplexen Quellen zu argumentieren und konkrete Details wiederzufinden. In der Praxis bedeutet das, dass der Assistent mit unterschiedlichen Formaten (Text, Fotos und Video) arbeiten kann – und das Ergebnis dadurch stärker „maßgeschneidert“ wirkt. Ist das die Art Personalisierung, die aus einem generischen Chatbot einen echten Assistenten macht? Darauf zielt es ab.

Außerdem betont das Unternehmen, dass es sich um eine Funktion handelt, die du bewusst aktivierst und appweise anpassen kannst. Die Personalisierung ist also nicht „ab Werk“ eingeschaltet – und genau das prägt den Charakter des gesamten Ansatzes.

Echte Beispiele: von der Werkstatt bis zur Reiseplanung

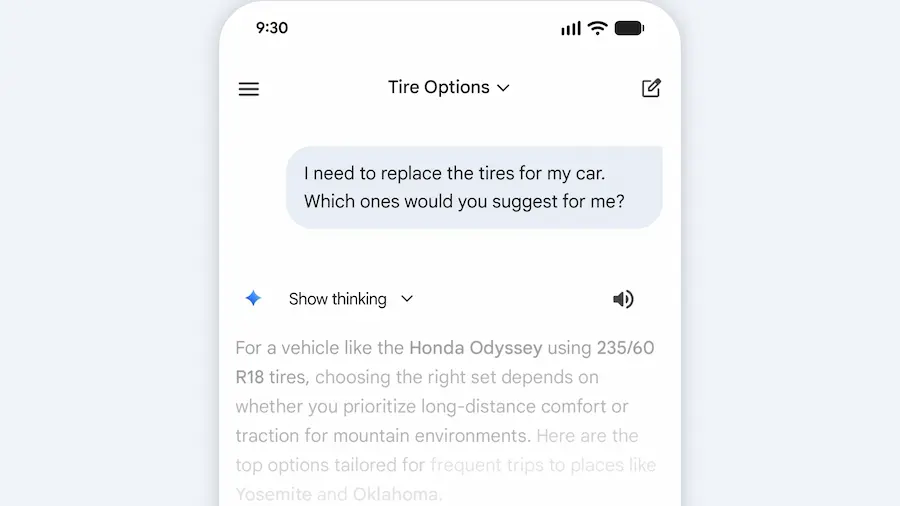

Um die Idee greifbar zu machen, enthält die Ankündigung ein sehr alltagsnahes Beispiel: ein Besuch in der Werkstatt zum Reifenwechsel. Die Person stellte fest, während sie schon in der Schlange stand, dass sie die Reifengröße ihres Vans nicht mehr wusste. Sie fragte Gemini – und während jeder Assistent generische Spezifikationen finden könnte, ist hier entscheidend, dass Gemini weiterging: Es schlug unterschiedliche Optionen je nach Nutzung vor (Alltag vs. Ganzjahresbedingungen) und ergänzte Bewertungen und Preise.

Der „persönliche“ Aspekt: Einen Teil dieser Empfehlungen stützte das System auf Informationen aus Google Fotos – konkret auf Hinweise zu Familien-Roadtrips. Und als am Tresen das Kennzeichen gebraucht wurde, musste die Person nicht zurück zum Auto oder Zeit mit Suchen verlieren: Gemini holte die Nummer aus einem in Fotos gespeicherten Bild. Sogar bei der exakten Ausstattungsvariante des Fahrzeugs half es, indem es in Gmail nachsah. Diese Art Verkettung (Foto fürs Kennzeichen, E-Mail für die Ausstattung) zeigt gut, was Google demonstrieren will: Es geht nicht nur ums Antworten, sondern darum, den richtigen Fakt dort zu finden, wo du ihn bereits hast.

In dieselbe Richtung nennt Google den Einsatz von Gemini für Empfehlungen zu Büchern, Serien, Kleidung und Reisen und hebt einen Fall zur Planung von Frühlingsurlaub hervor: Der Assistent analysierte Interessen und frühere Reisen in Gmail und Fotos, vermied dadurch typische Standardempfehlungen und schlug stattdessen spezifischere Alternativen vor – etwa eine Nachtzugstrecke und Brettspiele für unterwegs. Die Botschaft ist eindeutig: Wenn KI Kontext hat, klingt sie weniger wie ein Katalog aus Allgemeinplätzen. Und ja, es ist auch genau die Art Feature, bei der viele es „einfach mal ausprobieren“ wollen, um zu sehen, wie weit es geht.

Privatsphäre, Kontrolle und Verfügbarkeit: das solltest du wissen

Google stellt Privatsphäre als Grundpfeiler des Designs heraus. Personal Intelligence ist standardmäßig deaktiviert: Du schaltest es ein, du entscheidest, welche Apps verbunden werden, und du kannst es jederzeit wieder trennen. Ist es aktiv, greift Gemini auf Daten zu, um konkrete Anfragen zu beantworten und Aufgaben für dich zu erledigen. Google betont zudem einen Unterschied: Da diese Daten ohnehin bereits bei Google liegen, musst du sie nicht erst „woandershin“ übertragen, um die Personalisierung zu starten.

Ein weiterer relevanter Punkt für den Alltag ist die Nachvollziehbarkeit: Gemini soll versuchen, zu referenzieren oder zu erklären, woher eine Antwort stammt, die auf verbundenen Quellen basiert – damit du sie prüfen kannst. Wenn dich eine Antwort nicht überzeugt, kannst du nach Details fragen. Du kannst den Assistenten auch direkt korrigieren, etwa indem du Präferenzen anpasst. Zusätzlich gibt es die Möglichkeit, für eine konkrete Unterhaltung Antworten ohne Personalisierung neu zu generieren oder temporäre Chats zu nutzen, um ohne Personalisierung zu sprechen. Anders gesagt: Es entsteht ein „Modus mit Kontext“ und ein „Modus ohne Kontext“ – etwas, das viele Power-User zu schätzen wissen dürften.

Google ergänzt zudem Schutzmechanismen für sensible Themen: Gemini soll keine proaktiven Annahmen über heikle Daten wie Gesundheit treffen, kann diese aber verarbeiten, wenn du es ausdrücklich verlangst. Beim Modelltraining erklärt das Unternehmen, dass es nicht direkt mit deinem Gmail-Posteingang oder deiner Google-Fotos-Bibliothek trainiert; diese Quellen dienen dazu, Antworten zu referenzieren und aufzubauen. Trainiert wird mit begrenzten Informationen wie Prompts und Antworten, nachdem Maßnahmen angewendet wurden, um persönliche Daten zu filtern oder zu verschleiern. Das Beispiel ist recht anschaulich: Es geht nicht darum, dass das System dein Kennzeichen „lernt“, sondern dass es es finden kann, wenn du danach fragst.

Da es sich um eine Beta handelt, warnt Google auch vor möglichen Fehlern: ungenaue Antworten oder over-personalization, wenn das Modell Dinge miteinander verknüpft, die nicht zusammengehören. Feedback soll über den „Daumen runter“ kommen; außerdem räumt Google ein, dass es bei Nuancen oder zeitlichen Veränderungen haken kann – besonders, wenn sich Beziehungen oder Interessen ändern. Sprich: Die KI sieht viele Fotos auf einem Golfplatz und schließt daraus, dass du Golf liebst, obwohl du vielleicht nur wegen einer nahestehenden Person dort bist; in so einem Fall sollst du das ausdrücklich korrigieren.

Zur Verfügbarkeit: Der Zugriff wird in der kommenden Woche schrittweise für berechtigte Abonnenten von Google AI Pro und AI Ultra in den USA ausgerollt. Nach Aktivierung funktioniert es auf Web, Android und iOS sowie mit allen Modellen im Gemini-Auswahlmenü. Google sagt, man starte zunächst mit dieser begrenzten Gruppe, um zu lernen, und werde später auf weitere Länder und auch die kostenlose Stufe ausweiten. Außerdem soll es „bald“ in den AI Mode in der Suche kommen. Aktuell ist es für private Konten verfügbar, nicht für Workspace-Nutzer in Unternehmens-, Bildungs- oder Enterprise-Umgebungen.

Wenn auf dem Startbildschirm von Gemini keine Einladung erscheint, lässt sich das Feature auch über die Einstellungen aktivieren: Gemini öffnen, Settings aufrufen, Personal Intelligence antippen und unter Connected Apps etwa Gmail oder Fotos auswählen. Denn ja: Manchmal kommt die Zukunft als versteckter Schalter in den Einstellungen – traditionsgemäß.